denny britz, "deep learining's most import ideas"

2012 AlexNet

224*224 이미지 분류

2012년도 이미지넷 대회에서 1등

고전적 머신러닝이 아닌 딥러닝을 이용해 최초로 우승

blackbox로만 여겨지던 딥러닝의 성능을 확인

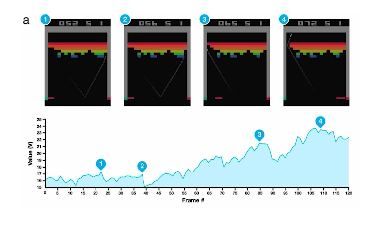

2013 DQN

Q러닝이라는 강화학습 방법론 사용

알파고

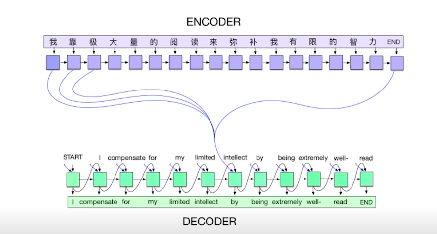

2014 Encoder / Decoder

NMT(Nueral machine translation) 문제를 풀기 위함

단어의 연속이 주어졌을 때 이를 잘 표현해서 다른 언어로 해석할지

이후 기계어 번역의 트랜드 번역

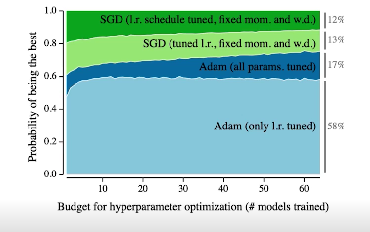

2014 Adam Optimizer

많은 사람들이 딥러닝 사용할 때 지금도 adam을 optimizer로 많이 사용

결과가 잘나옴

일반적으로 딥러닝 모델을 만들 때 하이퍼파라미터 서치를 많이 함. 이 때 컴퓨터 리소스가 많이 필요함. 이때 adam은 웬만하면 잘 되므로 많이 사용

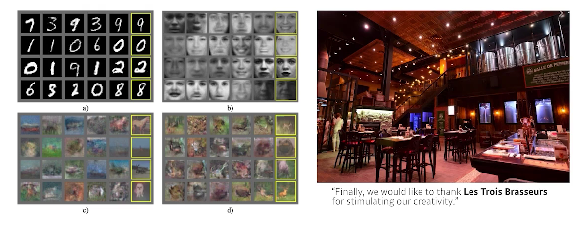

2015 GAN, ResNet

Generative adversarial network

이미지, 텍스트를 어떻게 생성할지

딥러닝에서 가장 중요한 background

2015 Residual netoworks

딥러닝이 딥러닝이도록 가능하게 한 논문

네트워크를 너무 깊게 쌓으면 성능이 좋지 않다? >> resnet의 등장으로 일부 해결. 전보다 레이어를 깊게 쌓을 수 있게됨

2017 Transformer

attention이 본인 영역에서 벗어나 다른 영역에서도 성능 good

2018 BERT

fine-tuned model

굉장히 다양한 단어들을 이용해 pre training 진행 후 소수의 network에 대해 training

2019 BIG Language models(GPT-3)

fine-tuning

1750억개의 파라미터로 구성

2020 self supervised learning

이미지 분류와 같은 분류문제를 풀려고 할 때 학습데이터는 한정적임

한정된 학습데이터를 넘어 label 없는 데이터까지 활용해 학습해 분류 문제를 해결하겠다

'AI Theory > key concept of AI' 카테고리의 다른 글

| 배열(array)과 파이썬 그래프 (0) | 2023.06.27 |

|---|---|

| 파이썬 더 잘 알기 (0) | 2023.06.26 |

| 분류 평가지표 (0) | 2023.05.07 |

| 데이터 퀼리티 높이기 (0) | 2022.12.01 |

| 데이터분석기초 (0) | 2022.09.14 |