[모두의 딥러닝] 로지스틱 회귀(logistic regression)

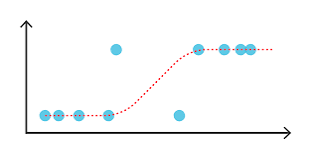

선형 회귀와 마찬가지로 적절한 선을 그려가는 과정

그러나 그 형태는 직선이 아닌 참(1)/거짓(0)을 구분하는 S자형 곡선

시그모이드 함수

로지스틱 회귀의 S자형 곡선을 그릴 수 있는 함수

e(자연상수) = 2.718...

시그모이드 함수 식은 아래와 같다.

a: 그래프의 경사도

b: 그래프 좌우 이동. 값 클수록 오른쪽 이동

a 값이 작을수록 오차 무한대로 커짐. a값이 커진다고해서 오차 무한대 아님

b값이 너무 크거나 작을수록 오차 무한대(2차함수 형태)

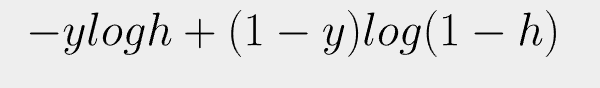

오차 공식

시그모이드 함수에서 a,b 구하는 방법: 경사 하강법

시그모이드 함수의 y값은 0에서 1 사이이다.

따라서 실제값이 1일때 예측값이 0이거나, 실제값이 0일때 예측값이 1인 경우 오차가 최대이다.

이는 로그 함수로 표현할 수 있다.

'AI Theory > key concept of AI' 카테고리의 다른 글

| [핸즈온 머신러닝] 머신러닝의 종류 (0) | 2022.08.16 |

|---|---|

| [모두의 딥러닝] 케라스에서 사용하는 대표적 오차 함수 (0) | 2022.07.29 |

| [모두의 딥러닝] 경사 하강법 (0) | 2022.07.29 |

| 68 95 99.7 규칙이란? (0) | 2022.07.20 |

| JSON (0) | 2022.07.19 |